| 일 | 월 | 화 | 수 | 목 | 금 | 토 |

|---|---|---|---|---|---|---|

| 1 | 2 | 3 | 4 | 5 | ||

| 6 | 7 | 8 | 9 | 10 | 11 | 12 |

| 13 | 14 | 15 | 16 | 17 | 18 | 19 |

| 20 | 21 | 22 | 23 | 24 | 25 | 26 |

| 27 | 28 | 29 | 30 |

- 복구

- sqldeveloper

- Memory

- psql

- TensorFlow

- docker

- postgre

- SQL

- 쿼리

- 리눅스

- GridSearchCV

- Docker image

- Python

- 시계열

- pgadmin

- 오라클

- 연결

- 도커이미지

- psycopg2

- LOG

- 파이썬

- 머신러닝

- cpu

- 도커

- jupyternotebook

- 교차검증

- GPU

- oracle

- Linux

- Jupyter

- Today

- Total

목록GPU (4)

areum

gpu메모리 사용 실시간으로 확인하기 자주쓰는 옵션 -n 실행간격을 변경 -d 이어지는 실행결과간의 차이를 강조하여 보여줌 -t 프로그램의 결과값만 출력 -v version확인 watch -n 1 nvidia-smi watch의 옵션인 -n 의미 n뒤에 숫자는 시간 간격을 의미합니다. 위 코드는 1초마다 갱신한다 라는 의미입니다.

1. 도커 컨테이너 생성 2. 도커 컨테이너 접속 3. 도커 컨터에너 나오기/중지 4. 도커 컨테이너 세부 정보 확인 1. 도커 컨테이너 생성하는 방법 docker run [옵션] 이미지명[:태그명] 주요 옵션 옵션 설명 --cpus CPU 개수 --cpuset-cpus 실행을 허용할 CPU 번호 (0-3, 0,1) --gpus 컨테이너에 추가할 GPU 장치(모든 GPU를 전달하려면 'all') --device 컨테이너에 호스트 장치 추가 --memory, -m 메모리 제한 --name 컨테이너 이름 지정 --volume , -v Bind mount a volume --publish , -p 컨테이너의 포트를 호스트에 게시 docker run --gpus ‘”device=숫자,숫자”’ --cpus=8 -..

tensorflow 를 이용하여 머신러닝을 실행할때, cpu나 gpu를 사용하게 된다. gpu를 시용하면 cpu만 사용하는 것에 비해 속도가 약 10배 이상 차이가 난다. 그렇기에 모델을 학습시킬때 gpu를 사용하는 것이 훨씬 효율적이며, cpu에 부하도 훨씬 적을 것입니다. 아래에서 gpu로 실행하도록 설정하는 두가지 방법에 대해서 알아보겠습니다. 아래 방법 사용 전 gpu device가 잡히는지 확인해야 합니다. from tensorflow.python.client import device_lib print(device_lib.list_local_devices()) 위 코드에서 gpu가 잡히는게 확인 되었다면 아래 방법을 실행하면 됩니다. 방법 1: 전체 GPU로 실행하기 import os os.en..

[Docker] 컨테이너 리소스 관리 및 모니터링-CPU,Memory

[Docker] 컨테이너 리소스 관리 및 모니터링-CPU,Memory

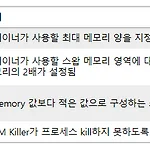

컨테이너를 생성 시 다양한 옵션이 존재하지만 오늘은 CPU와 Memory 관련해서 알아보도록 하겠습니다. 기본적으로 컨테이너를 생성할 때, 하드웨어 리소스의 사용 제한을 받지 않습니다. 그렇기 때문에 하나의 컨테이너가 모든 리소스를 사용할 수 있게 되고, 다른 컨테이너가 상대적으로 적은 리소스를 사용하게 됩니다. memory 리소스할당 cpu 리소스 할당 이미 생성된 container 리소스 재설정 리소스 확인 1. Memory 리소스 할당 docker run -d -m 500m [컨테이너이름:tag] docker run -d -m 1g --memory-reservation 500m [컨테이너 이름:tag] docker run -d -m 200m --memory-swap 300m [컨테이너 이름:tag]..